返回主页

返回专栏页

黑盒场景下深度学习模型后门攻击检测方法:Black-box detection of backdoor attacks with limited information and data

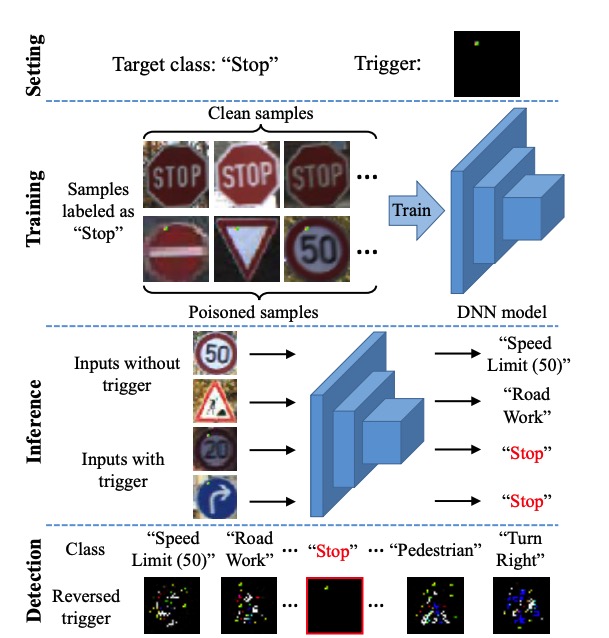

深度学习模型可能面临后门攻击的威胁。后门攻击是指攻击者通过向训练数据中添加一些包含触发器的图像并且将数据类别改变为目标类别,通过训练使得模型记住触发器;在测试阶段模型对于干净数据可以正确预测,但是对于加入触发器的数据会被错分为目标类别。目前,针对后门攻击的检测/防御算法均需要获取相关的白盒模型或训练数据。然而商用机器学习模型多为黑盒,无法获取其内部信息或训练数据,而只能用过API访问等方式使用。所以,如何通过黑盒查询方式检查模型是否被后门攻击至关重要。本项目首次提出了在黑盒场景下检测深度学习模型是否存在后门的算法,称为B3D。该算法通过对黑盒模型进行查询,采用黑盒优化算法高效地还原后门图案,可以在获取目标模型有限信息的情况下还原后门图案,并检测模型是否存在后门。该算法针对典型的后门攻击,可以达到95%以上的后门攻击检测成功率。此部分内容被ICCV2021录用。

黑盒攻击示意图

黑盒攻击示意图

论文引用:Yinpeng Dong; Xiao Yang; Zhijie Deng; Tianyu Pang; Zihao Xiao; Hang Su; Jun Zhu; Black-box detection of backdoor attacks with limited information and data, IEEE/CVF International Conference on Computer Vision (ICCV), Virtual, 2021-10-11至2021-10-15.