对抗概率分布训练: Adversarial Distributional Training for Robust Deep Learning

对抗训练(AT)是改善模型的最有效方法之一通过增加对抗性示例的训练数据来增强鲁棒性。但是,大多数现有的对抗训练方法采用特定的攻击手段来制作对抗示例,从 而导致对其他看不见的攻击具有不可靠的鲁棒性。此外,一次攻击该算法可能不足以探索扰动的空间。在项目中,我们提出了对抗式分布训练(ADT),这是一种学习健壮模型的新颖框架。ADT被公式化为最小-最大优化问题,其中内在最大化的目的是学习对抗分布以表征在熵调节器的作用下,围绕自然的潜在对抗性例子,外部最小化旨在通过最小 化预期来训练健壮模型最坏情况下的对抗分布损失。通过理论分析我们提出了一种解决ADT的通用算法,并提出了三种方法参数化对抗分布,范围从典型的高斯分布分配给灵活的隐式分配。多个基准的实证结果与最新的AT方法相比,验证ADT的有效性。 我们提出捕获周围的对抗性扰动的分布每个输入,而不仅仅是找到局部最对抗的点 来进行更通用的对抗训练,即对抗分布训练(ADT)。同传统的对抗训练相比,对于每个 自然输入,对抗训练发现最坏的情况对抗的样本,而ADT会学习最坏情况的对抗分布,包 括对抗性的样本。由于对抗性示例可能由各种攻击产生,因此我们希望这些对抗性样本 可能位于对抗性分布分配的区域高概率,从而使此分布上的预期损失最小化自然会导致 在相同威胁模型下,经过训练的分类器跨攻击的更好的泛化能力。为了更好的实现,我 们提供了三种参数化的方式,可以更好的训练相应的模型。实验结果表明,在大多数情 况下,相比于经典的对抗训练算法,通过参数分布的方法,可以更好的实现对抗鲁棒性 NSFC-REPORT-2020 的提升。

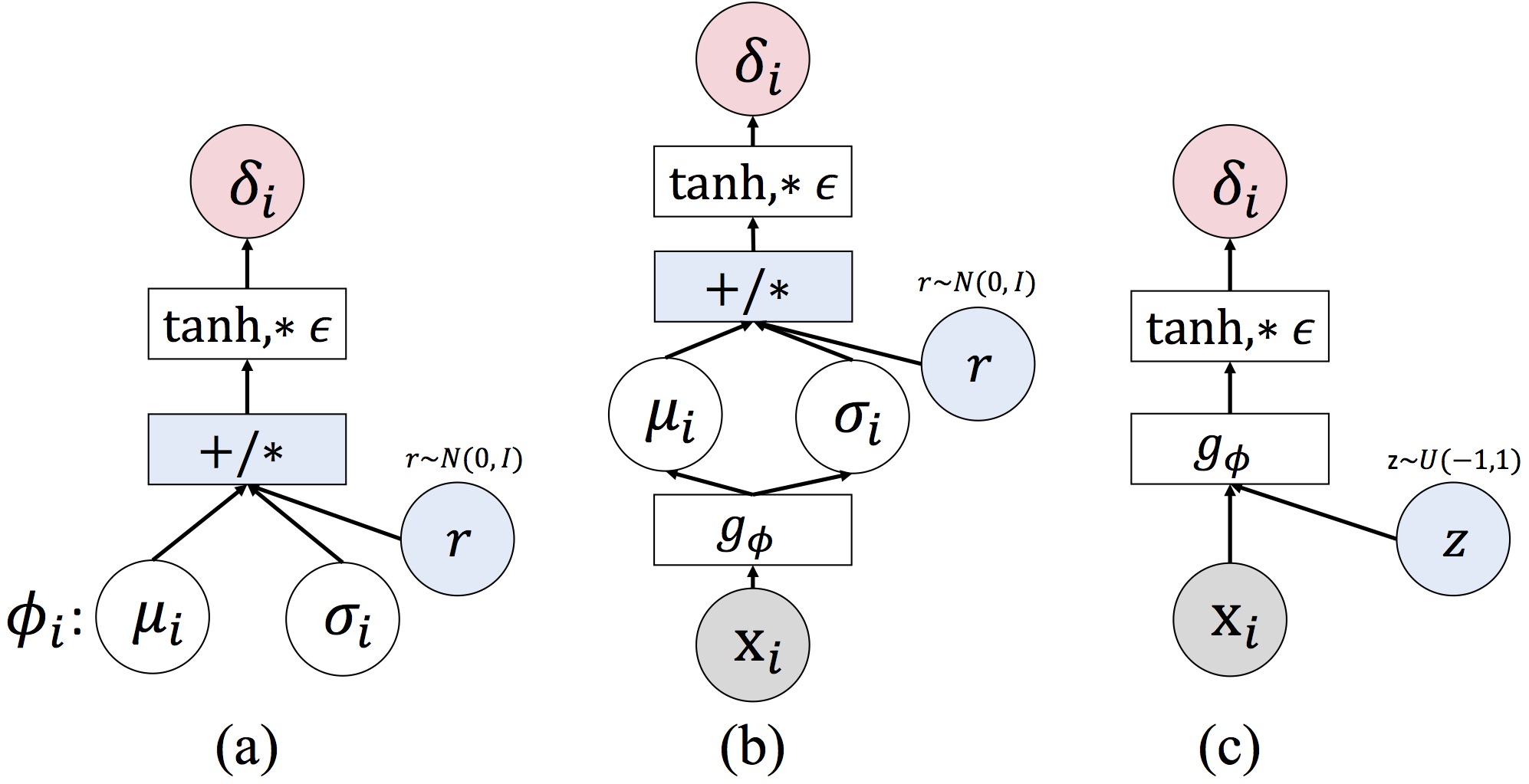

三种不同ADT方法的示意图

三种不同ADT方法的示意图

该成果在人工智能领域重要学术会议NeurIPS2020发表。

论文引用:Yinpeng Dong; Zhijie Deng; Tianyu Pang; Jun Zhu; Hang Su; Adversarial Distributional Training for Robust Deep Learning, Advances in Neural Information Processing Systems (NeurIPS), Online, 2020-12-6至2020-12-12.