返回主页

项目简介

深度学习尤其是深度神经网络在很多领域发挥着越来越重要的作用,但是近年来的研究发现深度神经网络的鲁棒性严重不足,很容易被对抗样本(正常样本加上刻意制造的噪声)欺骗。对抗样本具有很强的模型之间的迁移能力(能欺骗一个模型的对抗样本也能欺骗另一个模型)。该特点对于基于神经网络的应用系统的安全性提出了严峻挑战。

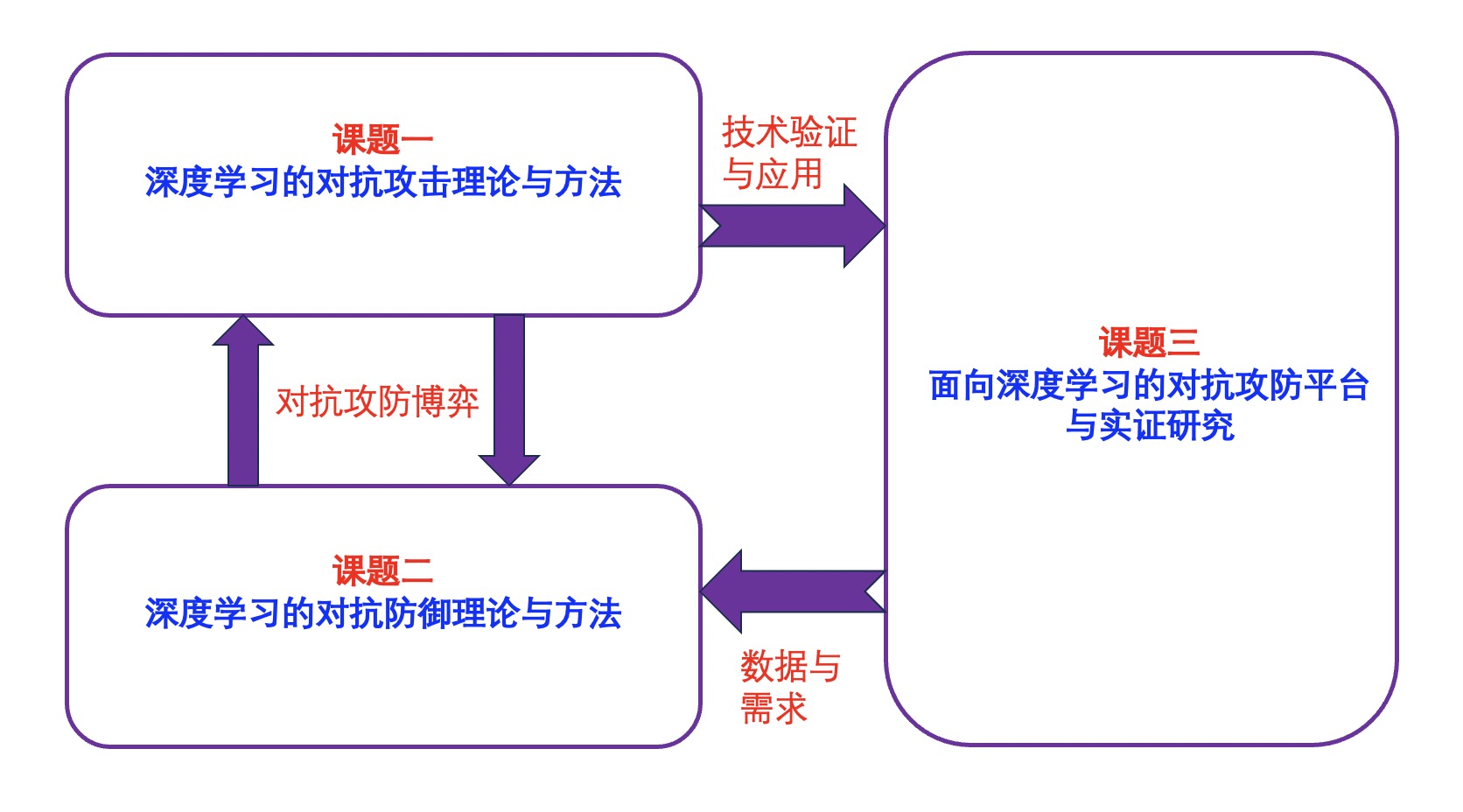

在国家自然科学基金委联合基金的资助下(批准号U19B2034,研究期限2020-2023),本项目从深度学习的对抗攻击、对抗防御和深度学习的攻防平台与实证三个方面开展研究。其中深度学习的对抗攻击和防御分别着眼于对抗攻击和防御算法,探索深度学习对抗攻防机理,为项目提供基础理论和关键技术支撑;算法平台针对对抗攻防算法的共性特点,提供面向深度学习对抗攻防的标准程序库,并提供图像、语音、视频、互联网图数据等不同类型数据的应用实证,支持深度学习模型的对抗攻防模型的算法研发与安全性评估。

三课题关系示意图

三课题关系示意图